基于Scrapy框架的Python资料收集爬虫学习入门,轻松掌握!

技术:Scrapy2.2.1+python3.8.2

概述

Scrapy是一款不可多得的经典爬虫框架,用过的人都说好!学完本节内容你能使用该框架开发出一款实用的 文章内容,图片下载,数据存储 ,高效率的 爬虫 。

详细

1.使用说明

目标 : 学完本节内容你能使用该框架开发出一款实用的 文章内容,图片下载,数据存储 ,高效率的 爬虫 。

2.运行的环境

win7(64位)+scrapy2.2.1

3.安装Scrapy

pip install scrapy -i http://pypi.douban.com/simple --trusted-host pypi.douban.com

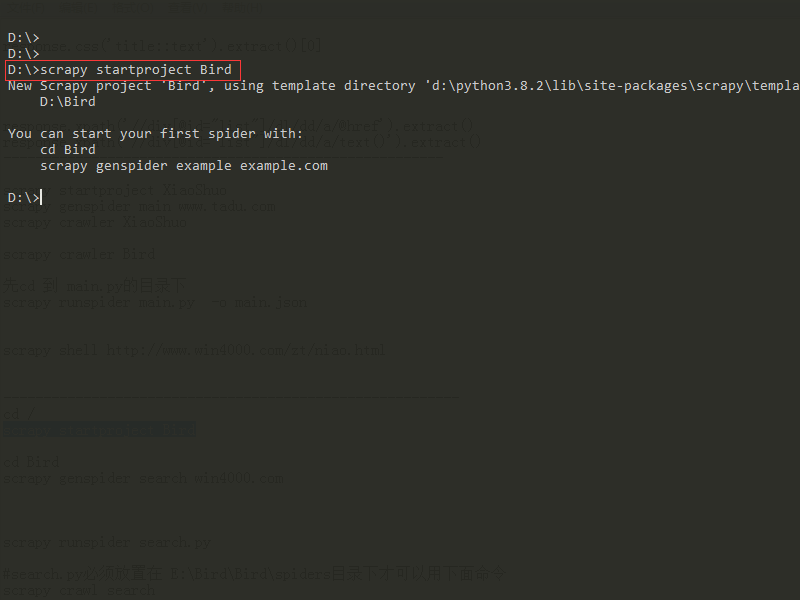

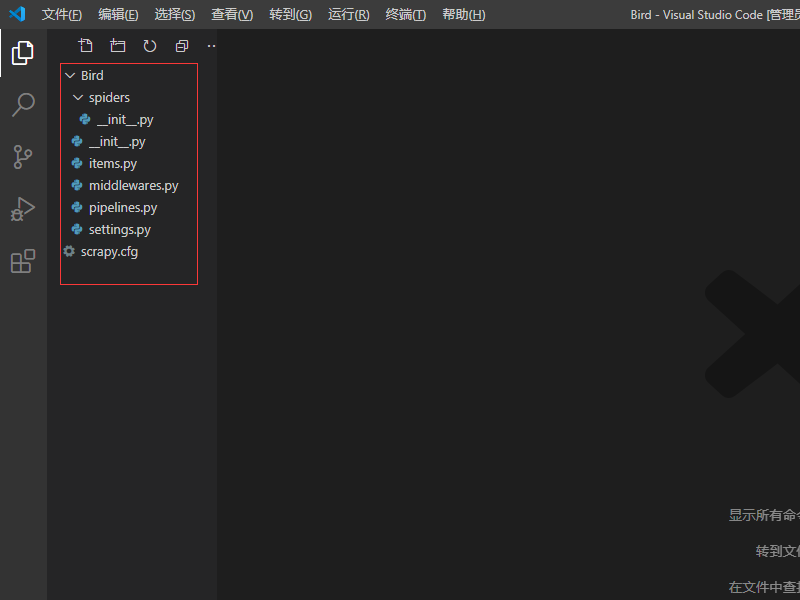

4.新建scrapy项目(项目路径自定,假如存放D盘)

a.打开命令窗口,cd 到 D盘,输入命令 scrapy startproject Bird ,回车执行,效果如下图 (两张图片):

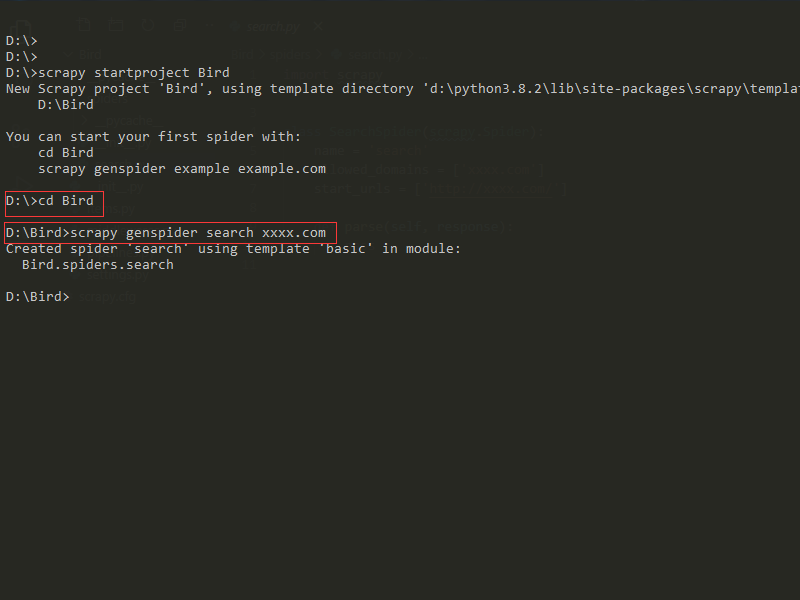

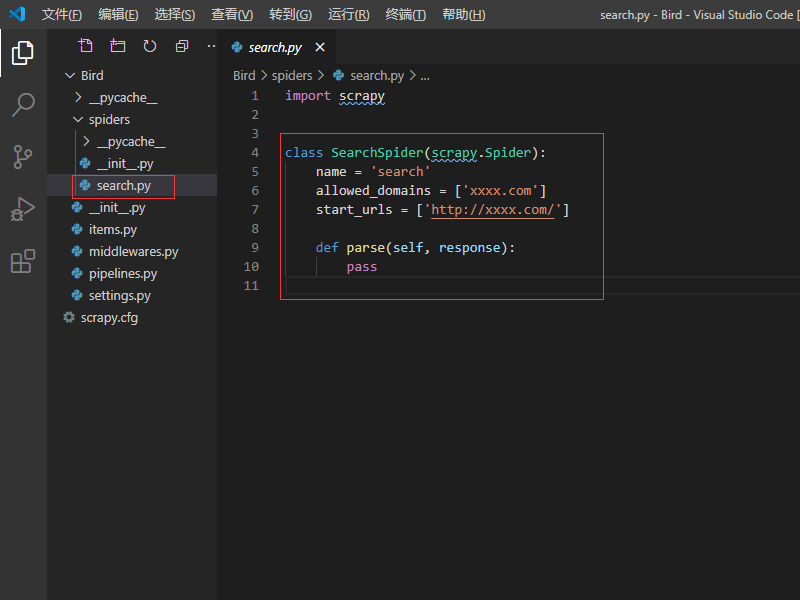

5.进入项目文件 :cd Bird,然后创建爬虫入口文件

a. scrapy genspider search xxxx.com , 回车执行,效果如下图 (两张图片):

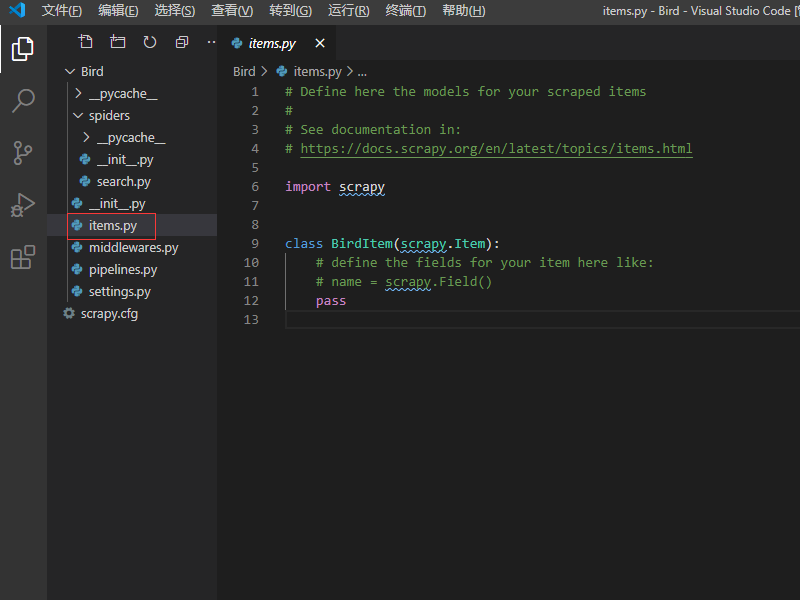

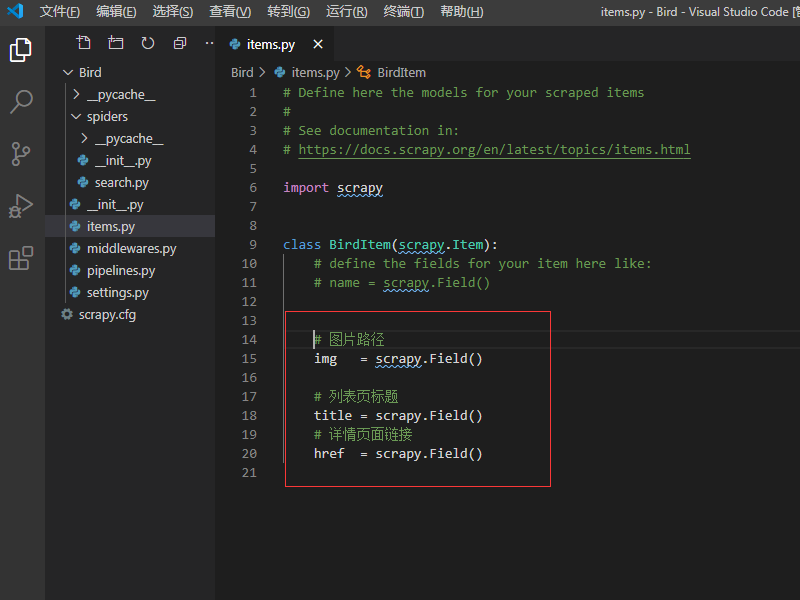

6.编写items.py文件

a.items.py,这是创建容器的地方,爬取的信息分别放到不同容器里

b.修改items.py文件存放爬虫信息

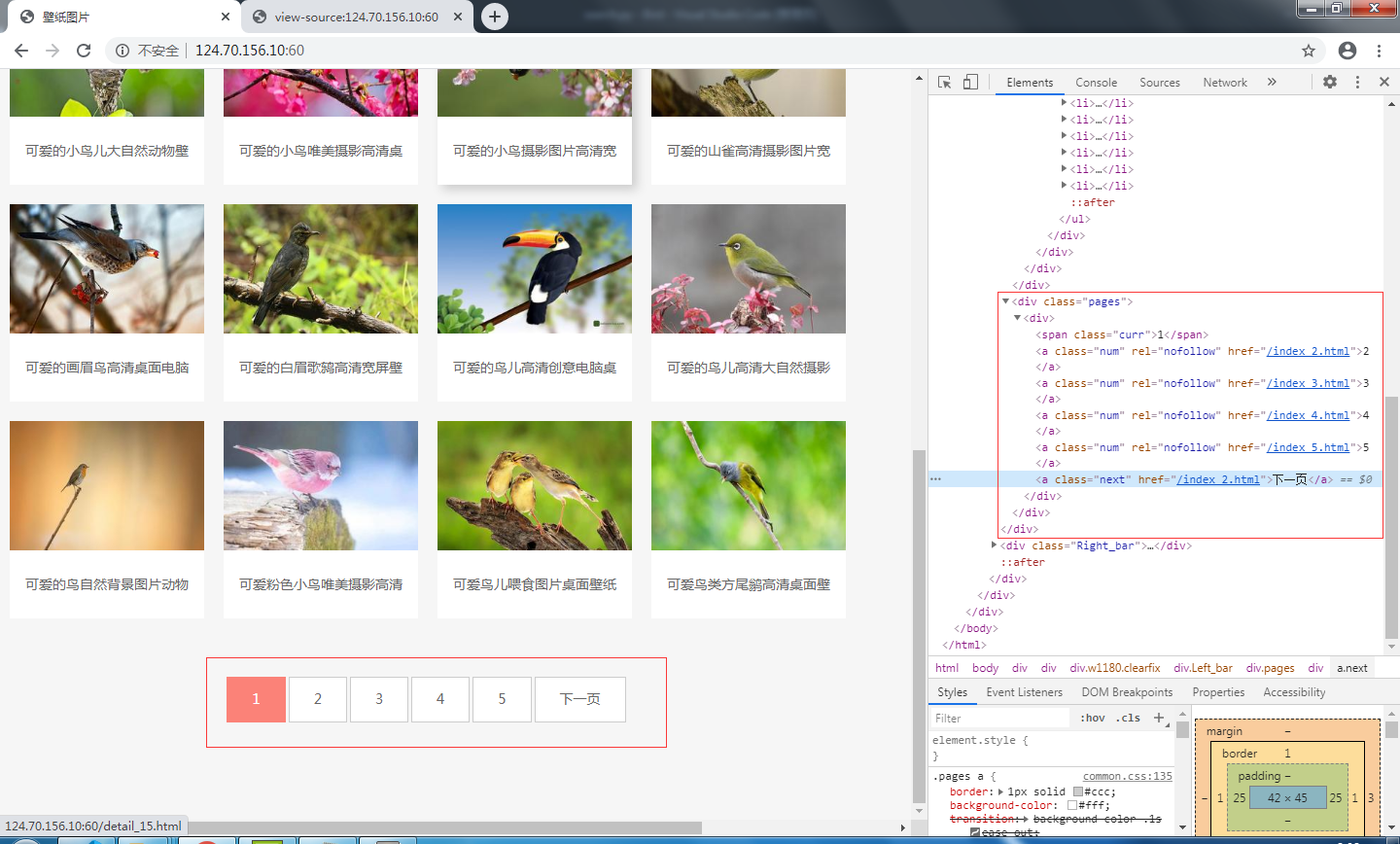

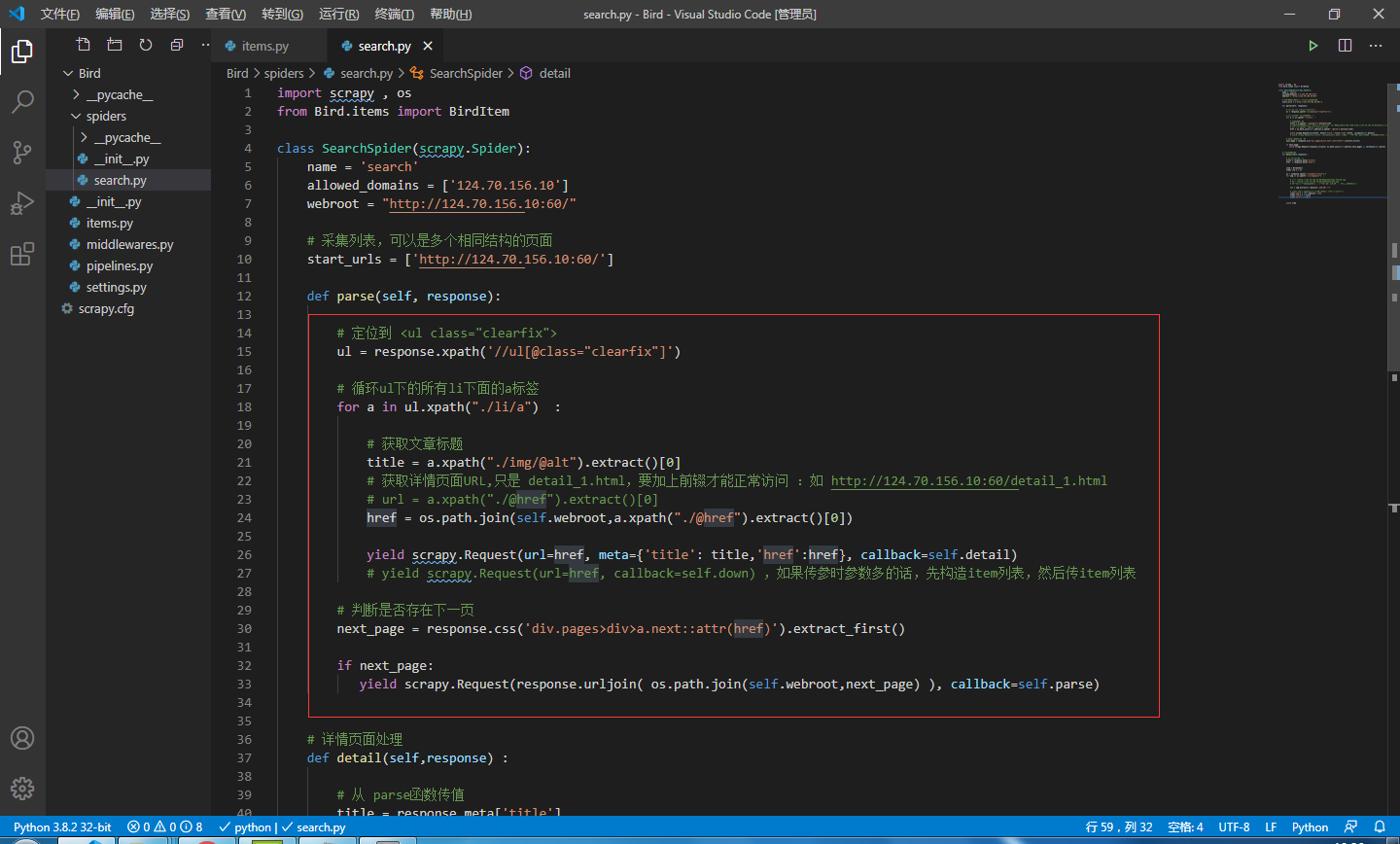

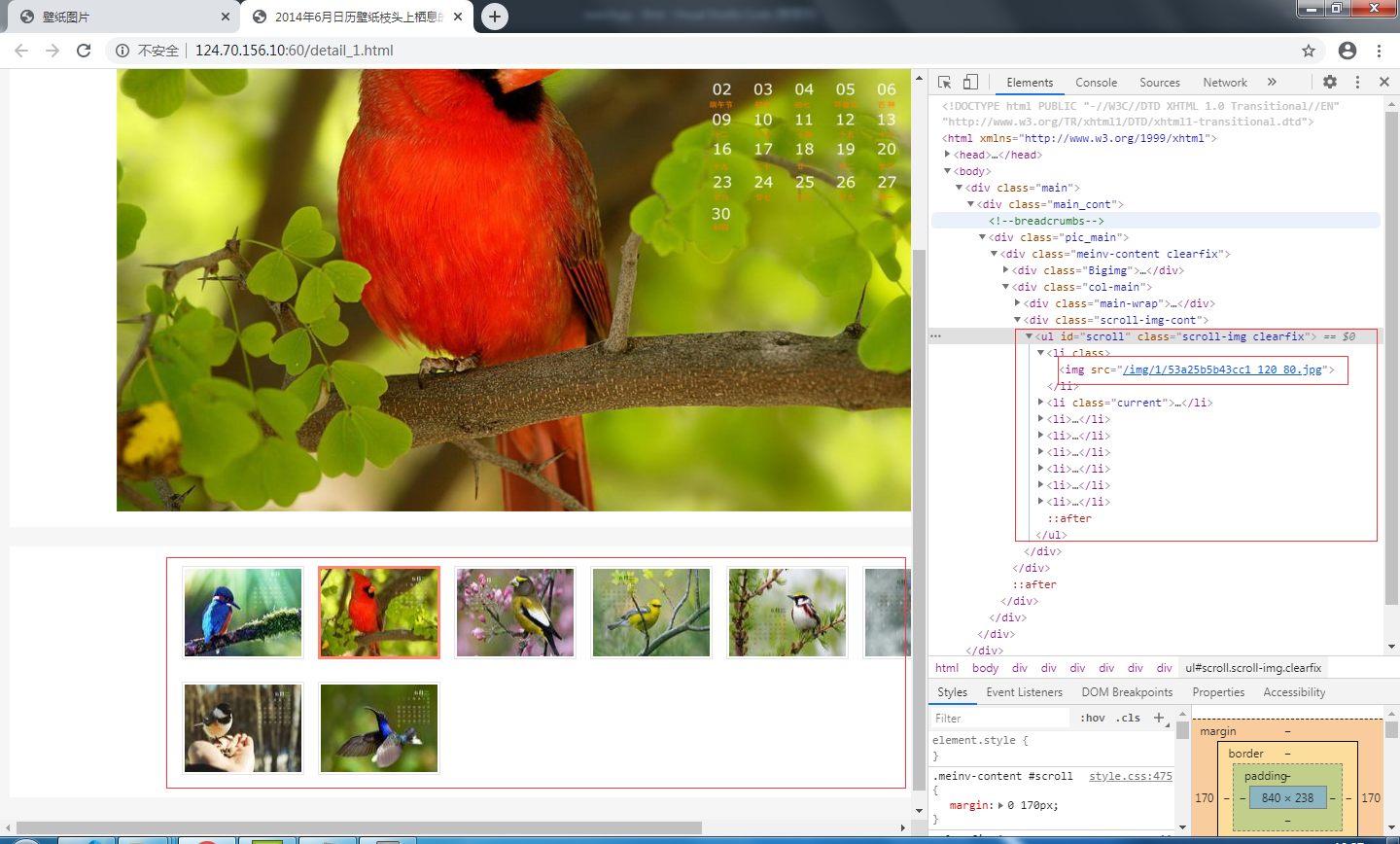

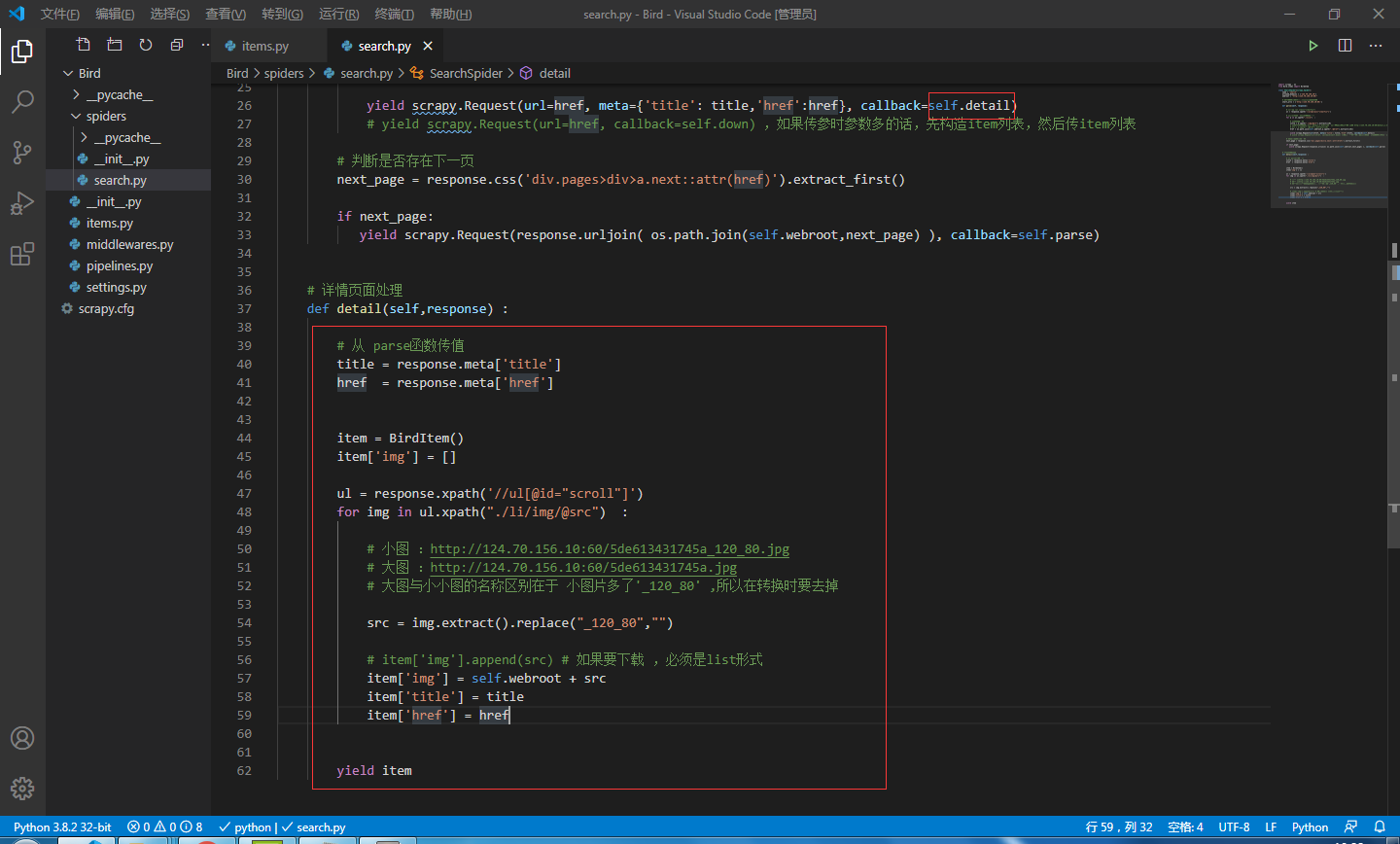

7.分析源目标网页,编写爬虫入口文件Bird/search.py

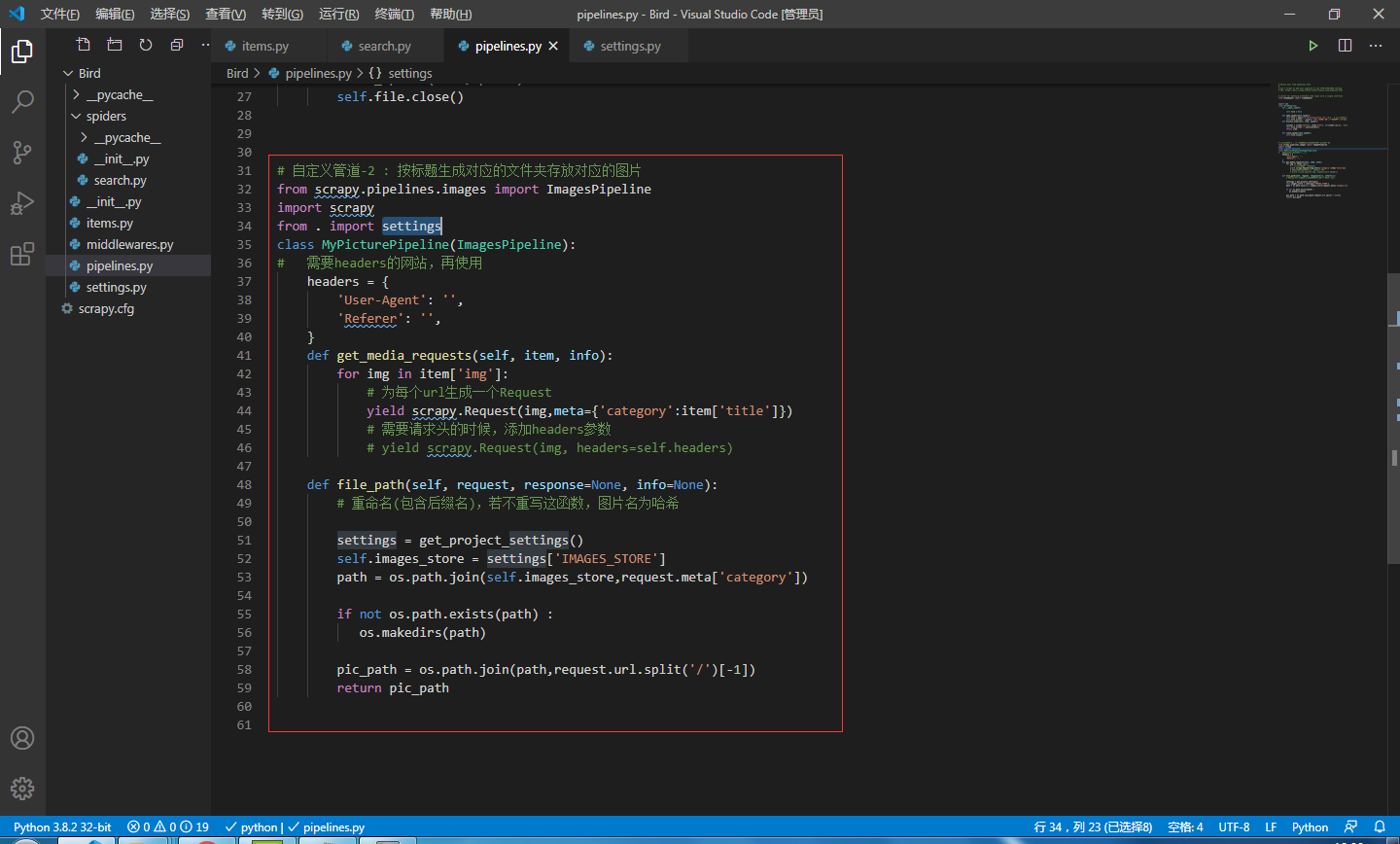

8.自定义管道文件pipelines.py的编写

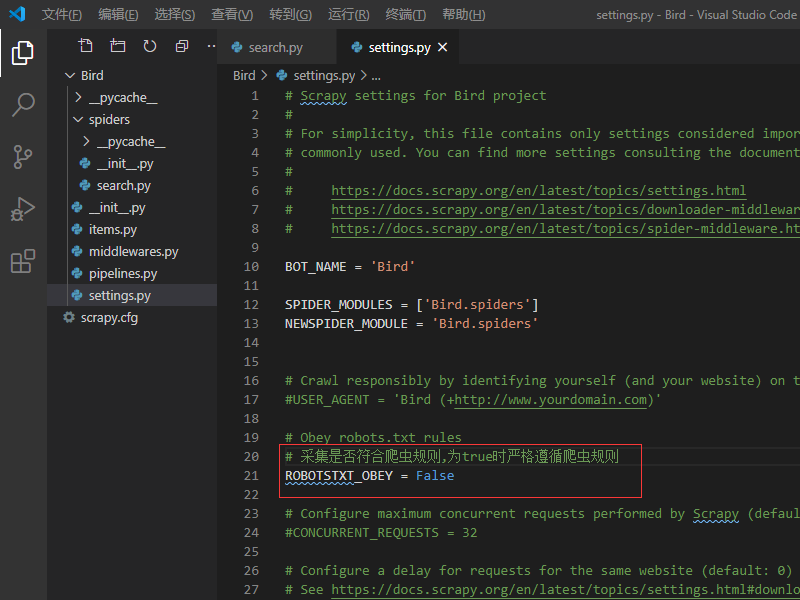

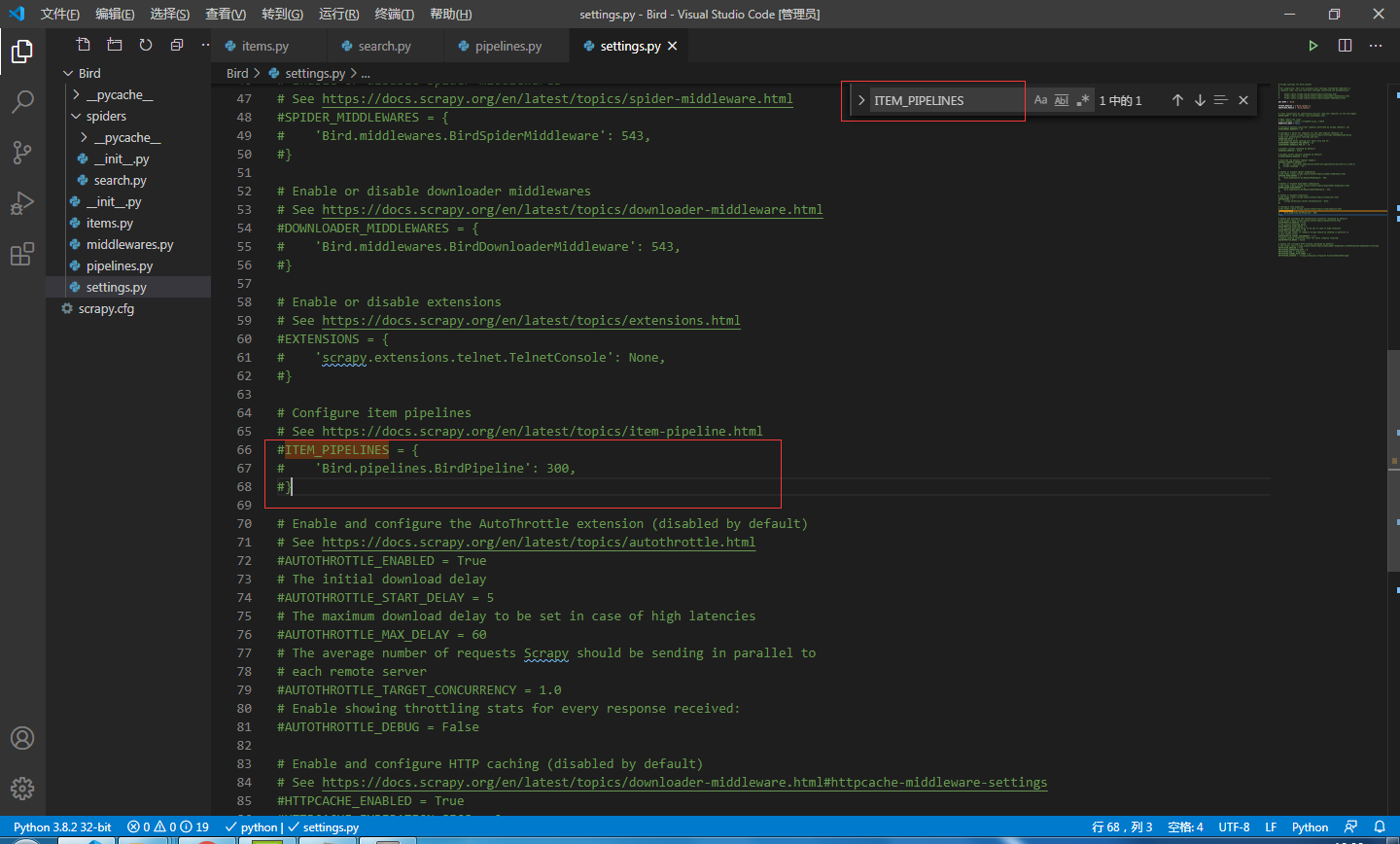

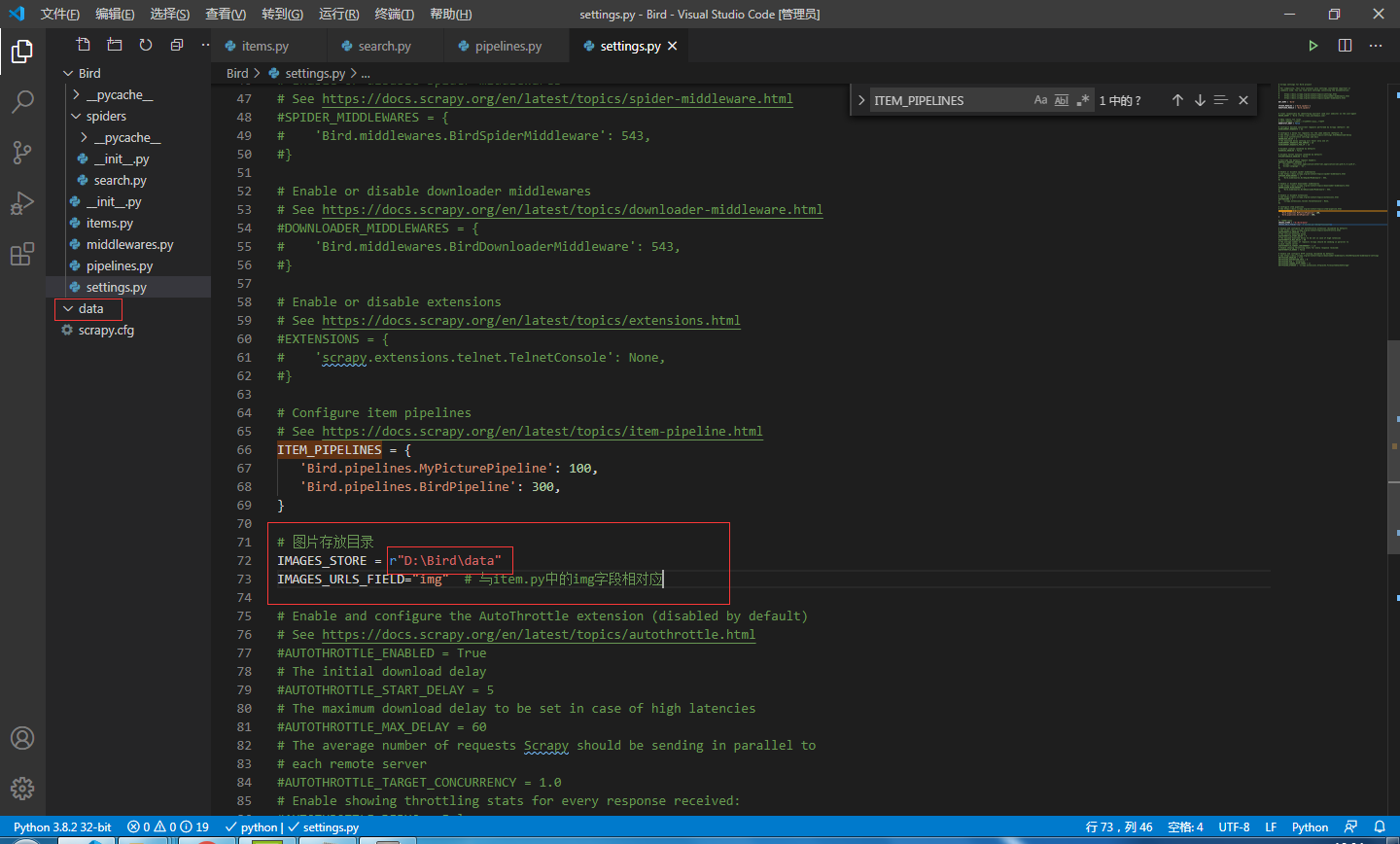

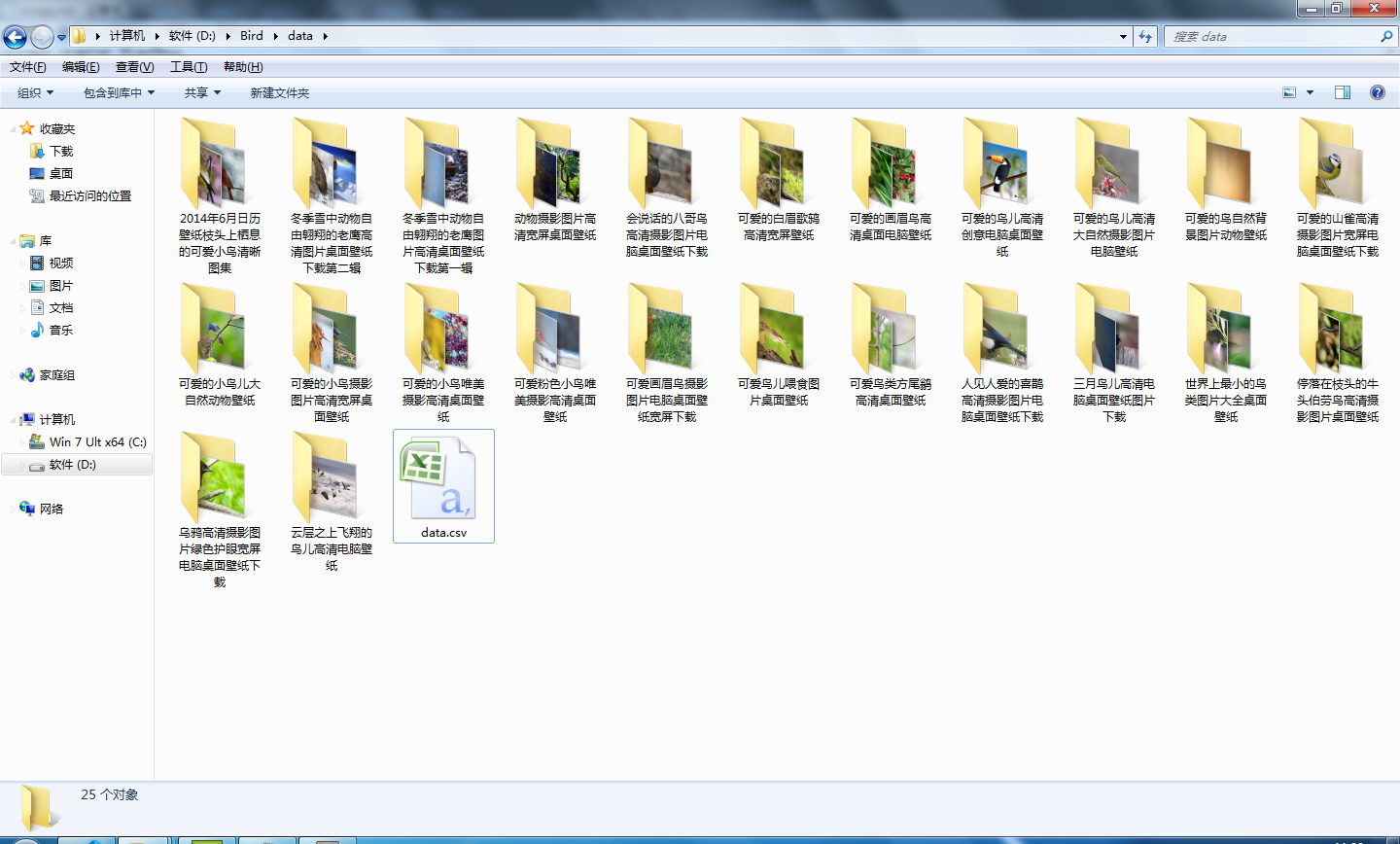

9.配置爬虫文件:settings.py(注意:D:\Bird\data文件夹需要自己手动创建)

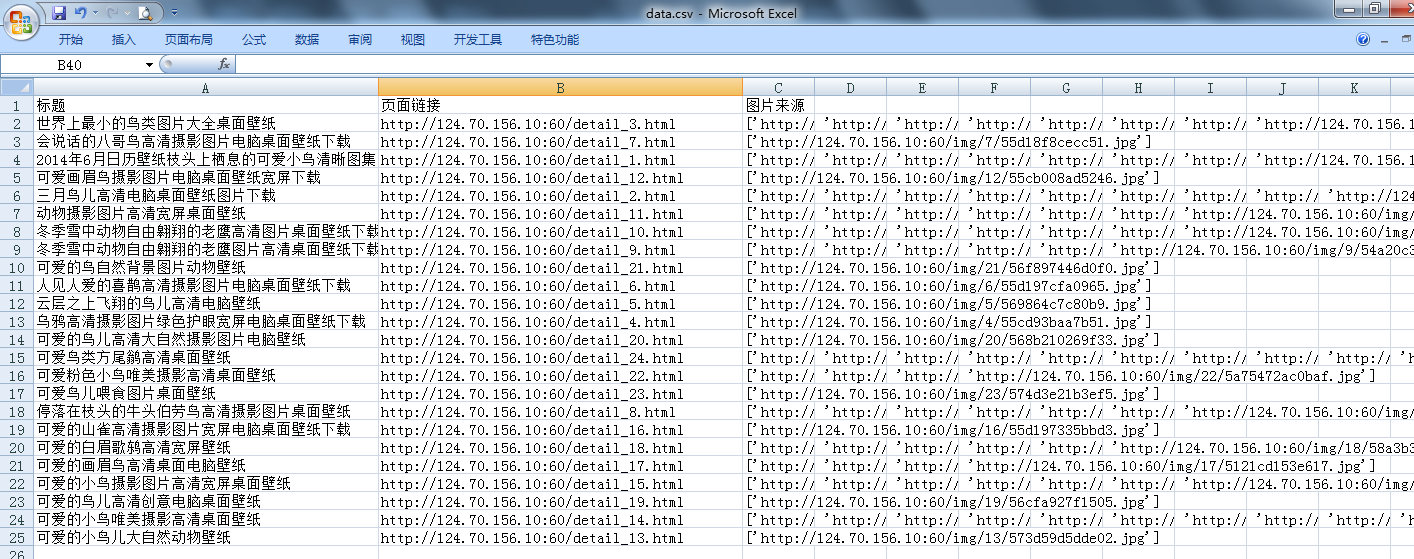

10.运行效果展示

本实例支付的费用只是购买源码的费用,如有疑问欢迎在文末留言交流,如需作者在线代码指导、定制等,在作者开启付费服务后,可以点击“购买服务”进行实时联系,请知悉,谢谢

手机上随时阅读、收藏该文章 ?请扫下方二维码